Tabla de Contenidos

- Fundamentos matemáticos: Modelización probabilista del fallo

- ¿Cómo se comportan los sistemas en el ciclo de vida?

- Mantenimiento predictivo: Hacia la ingeniería de fiabilidad

- Monitorización continua y paradigmas de mantenimiento

- Análisis de modos de fallo en la identificación de riesgos

- Tendencias: Inteligencia artificial y digital twins

- ¿Cómo impacta la sostenibilidad en la fiabilidad?

- Normativas y estándares en industrias críticas

- Sistemas autónomos y fiabilidad adaptativa

- Conclusion

- Referencias

La ingeniería de fiabilidad representa una disciplina multidisciplinaria que integra principios de teoría de probabilidades, análisis estadístico y métodos de optimización para cuantificar, predecir y mejorar el comportamiento de sistemas técnicos bajo condiciones operacionales reales.

Esta especialización técnica trasciende el concepto tradicional de calidad al incorporar la dimensión temporal como variable fundamental, permitiendo evaluar no solamente si un componente o sistema funciona correctamente, sino durante cuánto tiempo mantendrá su funcionalidad dentro de parámetros especificados.

El origen conceptual de esta disciplina se remonta a los trabajos pioneros de Waloddi Weibull en la década de 1950, quien desarrolló la distribución estadística que lleva su nombre para modelar los tiempos de fallo en rodamientos. Posteriormente, la industria aeroespacial y militar estadounidense expandió estos fundamentos, estableciendo los estándares MIL-STD que eventualmente evolucionarían hacia los marcos normativos contemporáneos como IEC 61508 y la ISO 14224; la cual, es una norma internacional que trata sobre la recopilación y el intercambio de datos de fiabilidad y mantenimiento de equipos en la industria de procesos.

Fundamentos matemáticos: Modelización probabilista del fallo

La cuantificación rigurosa de la fiabilidad se fundamenta en constructos matemáticos que describen el comportamiento aleatorio de los fallos. La función de fiabilidad R(t) expresa la probabilidad de que un sistema opere sin fallos durante un intervalo temporal definido, formulándose matemáticamente como

R(t) = P (T > t), donde T representa la variable aleatoria que describe el tiempo hasta el fallo. Esta función exhibe propiedades monótonas decrecientes, iniciando en

R (0) = 1 y convergiendo asintóticamente hacia cero conforme t tiende a infinito.

La tasa de fallo instantánea, designada mediante la función de riesgo (función hazard) λ(t), constituye otro descriptor fundamental que caracteriza la propensión al fallo en función del tiempo operacional acumulado.

Esta métrica se define como el límite de la probabilidad condicional de fallo en un intervalo infinitesimal, expresándose matemáticamente como λ(t) = f(t) / R(t), donde f(t) representa la función densidad de probabilidad del tiempo hasta el fallo. La relación entre estas funciones permite establecer que R(t) = exp[-∫λ(τ)dτ], proporcionando un marco teórico cohesivo para el análisis predictivo.

¿Cómo se comportan los sistemas en el ciclo de vida?

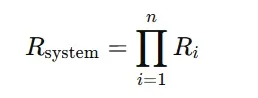

La configuración topológica de los componentes dentro de un sistema determina de manera fundamental su fiabilidad agregada. En los sistemas en serie, donde el fallo de cualquier componente provoca el fallo de todo el sistema, la fiabilidad total se calcula como:

Donde Ri es la fiabilidad de cada componente. En esta configuración, la fiabilidad del sistema está limitada por los componentes menos confiables, representando el caso más desfavorable desde la perspectiva de disponibilidad operacional.

En contraste, los sistemas en paralelo implementan redundancia activa: múltiples componentes ejecutan simultáneamente la misma función, y el sistema solo falla si todos los componentes fallan, aumentando significativamente la resiliencia operativa.

Los sistemas k de n, en los que al menos k de n componentes deben operar correctamente, permiten ajustar la fiabilidad según los requisitos de disponibilidad y las restricciones económicas, usando la distribución binomial acumulada para su cálculo.

En la práctica, los sistemas raramente presentan topologías puramente serie o paralelo. Por ello, se emplean técnicas avanzadas como diagramas de bloques de fiabilidad (RBD), árboles de fallo (FTA) y diagramas de Markov, que permiten modelar arquitecturas complejas con dependencias funcionales, modos de fallo comunes, reconfiguración dinámica y variaciones de fiabilidad a lo largo del ciclo de vida del sistema, incluyendo desgaste, mantenimiento y actualizaciones.

Mantenimiento predictivo: Hacia la ingeniería de fiabilidad

La estrategia de mantenimiento constituye una palanca fundamental para maximizar la disponibilidad operacional mientras se minimizan los costos del ciclo de vida. El mantenimiento correctivo o reactivo, implementado históricamente en la mayoría de las instalaciones industriales, opera bajo el paradigma de intervención posterior al fallo, resultando en tiempos de inactividad impredecibles y costos operacionales elevados debido a fallos catastróficos secundarios y pérdidas de producción.

El mantenimiento preventivo basado en edad o tiempo calendario implementa intervenciones programadas con periodicidad fija independiente de la condición real del equipo.

La optimización del intervalo de mantenimiento requiere balancear el costo de intervenciones prematuras contra el riesgo de fallos entre intervalos, formulándose típicamente como un problema de minimización del costo esperado por unidad de tiempo operacional mediante teoría de renovación.

Monitorización continua y paradigmas de mantenimiento

El mantenimiento basado en condición (CBM) y su evolución hacia el mantenimiento predictivo representan la frontera tecnológica actual, aprovechando sensórica avanzada y algoritmos de procesamiento de señales para cuantificar el estado de salud de componentes críticos mediante indicadores de degradación mensurables.

Técnicas como análisis de vibraciones mediante transformadas de Fourier y wavelets, termografía infrarroja, análisis de aceites mediante espectrometría y monitorización de descargas parciales en activos eléctricos permiten detectar precursores de fallo con anticipación suficiente para planificar intervenciones optimizadas.

La modelización matemática del CBM emplea típicamente procesos estocásticos como modelos de degradación gamma o movimiento Browniano con deriva para describir la evolución temporal del indicador de salud, estableciendo umbrales de alerta y alarma mediante técnicas de optimización que consideran los costos de falso positivo (intervención innecesaria) versus falso negativo (fallo no detectado).

El valor esperado del tiempo óptimo de reemplazo se determina mediante programación dinámica estocástica o algoritmos de horizonte rodante.

Análisis de modos de fallo en la identificación de riesgos

El FMEA (Failure Mode and Effects Analysis) representa una técnica estructurada bottom-up para identificar sistemáticamente modos de fallo potenciales, sus causas raíz y efectos en el desempeño del sistema.

Esta metodología, originada en el sector aeroespacial mediante MIL-STD-1629, se ha expandido hacia prácticamente todos los sectores industriales, evolucionando hacia variantes especializadas como FMECA (incorporando criticidad cuantitativa) y DFMEA (orientado al diseño).

El proceso FMEA examina cada componente funcional identificando sus modos de fallo característicos, determinando los mecanismos físicos causantes mediante análisis de esfuerzos, degradación o errores operacionales, evaluando los efectos locales y sistémicos, y finalmente estableciendo controles preventivos o detectivos.

La priorización de acciones correctivas se fundamenta en el Número de Prioridad de Riesgo (RPN), calculado como el producto de la severidad, ocurrencia y detectabilidad, aunque metodologías contemporáneas como el FMEA según VDA/AIAG han introducido matrices de priorización de acción más sofisticadas.

Tendencias: Inteligencia artificial y digital twins

La ingeniería de fiabilidad está siendo transformada por la inteligencia artificial (IA) y los gemelos digitales, tecnologías centrales de la Cuarta Revolución Industrial. Los algoritmos de IA, incluyendo redes neuronales profundas y modelos de supervivencia como el Modelo de Riesgos Proporcionales de Cox con embeddings neuronales, permiten identificar patrones complejos de degradación en datos multivariados de sensores, sin depender de modelización física tradicional.

Los gemelos digitales crean réplicas virtuales de activos físicos que evolucionan en tiempo real mediante la integración continua de datos operacionales. Combinan modelos multifísicos, ecuaciones diferenciales estocásticas y algoritmos bayesianos para actualizar de manera precisa la vida residual útil (RUL) de cada activo.

Gracias a estas tecnologías, es posible realizar pronósticos individualizados por activo, considerando su historial operativo y condiciones ambientales específicas. Esto supera las limitaciones de los modelos poblacionales tradicionales y potencia la optimización del mantenimiento predictivo y la fiabilidad avanzada.

¿Cómo impacta la sostenibilidad en la fiabilidad?

La creciente imperatividad de la sostenibilidad ambiental está redefiniendo objetivos de optimización en ingeniería de fiabilidad. El concepto tradicional de maximizar disponibilidad operacional debe ahora balancearse con la minimización de huella de carbono, consumo energético y generación de residuos a lo largo del ciclo de vida.

Esta multi-dimensionalidad requiere marcos de optimización multiobjetivo mediante técnicas de frontera de Pareto o funciones de utilidad ponderadas que reflejen preferencias organizacionales respecto a trade-offs entre disponibilidad, costo y sostenibilidad.

El análisis de ciclo de vida (LCA) integrado con ingeniería de fiabilidad permite cuantificar impactos ambientales no solamente de la producción y disposición final, sino también de intervenciones de mantenimiento, consumo de repuestos y energía operacional considerando las incertidumbres inherentes a la vida útil estocástica de componentes. Metodologías emergentes como eco-Reliability buscan diseñar sistemas que optimicen simultáneamente fiabilidad intrínseca y degradación ambiental mínima.

Normativas y estándares en industrias críticas

El desarrollo y operación de sistemas en sectores regulados demanda cumplimiento de estándares internacionales que codifican mejores prácticas en ingeniería de fiabilidad. El estándar IEC 61508 establece requisitos funcionales de seguridad para sistemas eléctricos, electrónicos y electrónicos programables, definiendo niveles de integridad de seguridad (SIL) desde SIL 1 hasta SIL 4 con requisitos progresivamente rigurosos de probabilidad de fallo bajo demanda, típicamente variando desde 10^-2 hasta 10^-5 por hora de operación.

Sectores específicos han desarrollado adaptaciones especializadas como IEC 61511 para la industria de procesos, ISO 26262 para sistemas automotrices y EN 50126/50128/50129 para aplicaciones ferroviarias, cada uno incorporando requisitos particulares reflejando las características de riesgo y consecuencias de fallo en su dominio.

La demostración de conformidad con estos estándares requiere evidencia documentada mediante análisis cuantitativos de fiabilidad, planes de verificación y validación, y trazabilidad completa desde requisitos hasta implementación.

Sistemas autónomos y fiabilidad adaptativa

Los sistemas autónomos contemporáneos, desde vehículos autónomos hasta robots colaborativos y sistemas de gestión energética inteligente, presentan desafíos inéditos para la ingeniería de fiabilidad.

La incorporación de algoritmos de inteligencia artificial introduce elementos de aleatoriedad y comportamiento emergente que desafían los paradigmas determinísticos tradicionales de análisis de seguridad.

Los conceptos de fiabilidad adaptativa y arquitecturas de autodiagnóstico y auto-reparación (self-healing systems) representan paradigmas emergentes donde los sistemas no solamente detectan degradación sino implementan autónomamente estrategias de reconfiguración o ajuste paramétrico para mantener desempeño aceptable ante fallos incipientes.

La formalización matemática de estos comportamientos adaptativos mediante teoría de control óptimo estocástico y procesos de decisión de Markov parcialmente observables constituye un área activa de investigación con implicaciones profundas para la próxima generación de sistemas técnicos resilientes.

Conclusion

La integración de inteligencia artificial y gemelos digitales representa un avance significativo para la fiabilidad en la ingeniería moderna. Estas tecnologías permiten pronósticos individualizados de vida útil de activos, optimizan el mantenimiento predictivo y transforman los modelos tradicionales basados en poblaciones en sistemas adaptativos y precisos. En consecuencia, la fiabilidad deja de ser un objetivo estático y se convierte en un proceso dinámico, fundamentado en datos reales y análisis avanzados, asegurando operaciones más seguras, eficientes y resilientes.

Referencias

- ISO 14224:2016: https://www-iso-org.

- Mao, R., Wan, L., Zhou, M., & Li, D. (2025). Cox-Sage: Enhancing Cox proportional hazards model with interpretable graph neural networks for cancer prognosis. Briefings in Bioinformatics, 26(2), bbaf108. https://doi.org/10.1093/bib/bbaf108

- https://www.sciencedirect.com/science/article/abs/pii